تستخدمها السلطات لقياس الطاقة الإيجابية

كاميرات التعرف إلى تعابير الوجه ترصد مشاعر الصينيين وتثير حفيظة «حقوق الإنسان»

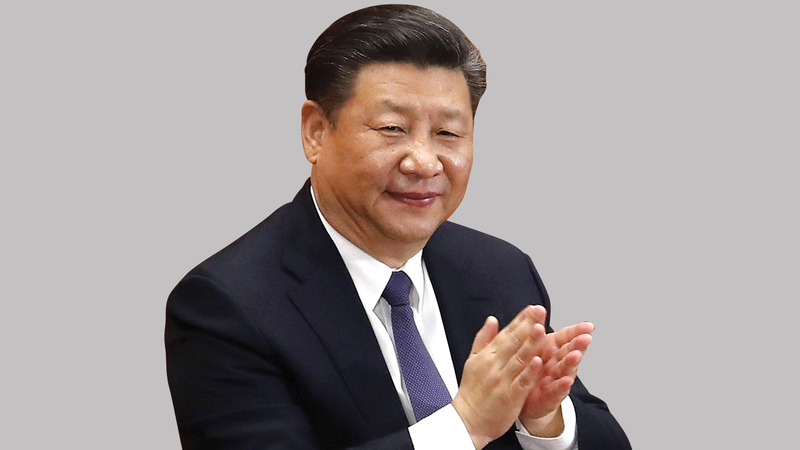

تستخدم السلطات الصينية على نطاق واسع تقنية ما يسمى «التعرف إلى المشاعر» منذ أن طلب الرئيس شي جين بينغ من شعبه التحلي بـ«طاقة إيجابية» كجزء من حملة أيديولوجية لتشجيع أنواع معينة من التعبير، والحد من أنواع أخرى، إلا أن البعض، حتى في الصين، يراها مسألة تتعلق بحقوق الإنسان.

وتستطيع تقنيات التعرف إلى المشاعر، والتي ترصد تعبيرات الوجه في حالة الغضب والحزن والسعادة والملل، بالإضافة إلى البيانات الحيوية الأخرى؛ قراءة مشاعر الشخص بناءً على سمات مثل حركات عضلات وجهه، ونغمة صوته، وحركات جسمه، وإشاراته البيومترية الأخرى. وتتفوق هذه التقنية على تقنيات التعرف إلى الوجه التي تقارن ببساطة الوجوه لتحديد تطابقها مع بيانات أصحابها.

ويعتقد عدد متزايد من الباحثين والمحامين ونشطاء حقوق الإنسان أن لهذه التقنية آثاراً خطيرة على حقوق الإنسان والخصوصية وحرية التعبير. وفي الوقت الذي من المتوقع أن تصل فيه قيمة هذه الصناعة في الأسواق العالمية إلى ما يقرب من 36 مليار دولار بحلول عام 2023، بمعدل نمو يقارب 30٪ سنوياً، تقول جماعات حقوق الإنسان إنه يجب اتخاذ إجراءات الآن بشأنها.

ويقول المدير العام لشركة تغوسيس المتخصصة في تقنية التعرف إلى المشاعر، تشين وي «الناس هنا في الصين ليسوا سعداء بهذه التكنولوجيا، ولكن ليس لديهم خيار آخر، فإذا قالت الشرطة إنه يجب أن تكون هناك كاميرات في المجتمع، فسيتعين على الناس التعايش معها، هناك دائماً مثل هذا الطلب ونحن نوفي به دوماً». وتلعب الشركة دوراً في كل جانب من جوانب المجتمع الصيني تقريباً.

التخويف والرقابة

يقع المكتب الرئيس لشركة تغوسيس في مدينة شينزين، وترحب الشركة بالزائرين عند المدخل من خلال سلسلة من الكاميرات التي تلتقط صورهم على شاشة كبيرة تعرض درجة حرارة الجسم، إلى جانب تقديرات العمر، وإحصاءات أخرى. ويقول تشين إن النظام الموجود في المدخل هو الأكثر مبيعاً للشركة في الوقت الحالي، بسبب ارتفاع الطلب عليه خلال جائحة فيروس كورونا.

ويشيد تشين بأحد جوانب هذه التقنية التي تتمثل في تعرفها إلى السلوك الخطير من قبل السجناء، واكتشاف المجرمين المحتملين عند نقاط تفتيش الشرطة، والتلاميذ الذين يعانون مشكلات في المدارس، وكبار السن الذين يعانون الخرف في دور الرعاية.

وتم تركيب أنظمة تغوسيس في نحو 300 سجن ومركز احتجاز في جميع أنحاء الصين، حيث يتم استخدام 60 ألف كاميرا. ويقول تشين: «العنف والانتحار شائعان جداً في مراكز الاحتجاز، حتى لو لم تقم الشرطة في الوقت الحاضر بضرب السجناء، فهم يحاولون إرهاقهم من خلال عدم السماح لهم بالنوم، ونتيجة لذلك، سيصاب بعض السجناء بانهيار عقلي ويحاولون قتل أنفسهم، وسيساعد نظامنا على منع حدوث ذلك».

ويقول أيضاً إنه بما أن السجناء يعرفون أنهم يخضعون للمراقبة بواسطة هذا النظام (24 ساعة في اليوم في الوقت الفعلي)، فقد أصبحوا أكثر قابلية للانقياد، وهو أمر إيجابي بالنسبة للسلطات على جبهات عدة، «لأنهم يعرفون ما يفعله النظام، ولهذا لن يحاولوا بإرادتهم انتهاك قواعد معينة».

إلى جانب السجون ونقاط التفتيش التابعة للشرطة، يتم استخدام أنظمة الشركة في المدارس لمراقبة المعلمين والتلاميذ والموظفين، وفي دور رعاية كبار السن لمعرفة ما إذا كانوا يتعرضون لمكروه، ورصد تغيرات الحالة الانفعالية للسكان في مراكز التسوق ومواقف السيارات.

وفي حين أن استخدام تقنية التعرف إلى المشاعر في المدارس في الصين قد أثار بعض الانتقادات، كان هناك القليل جداً من الجدل حول استخدامها من قبل السلطات على المواطنين.

وبينما يقول تشين إنه يدرك مخاوف المواطنين، فإنه يؤكد أن النظام ساعد على الحد من حوادث العنف. ويستشهد بحادثة طعن فيها أحد حراس الأمن نحو 41 شخصاً في مقاطعة جوانجشي بجنوب الصين في يونيو الماضي، ويزعم تشين أنه كان من الممكن منع وقوع مثل تلك الحادثة بواسطة هذه التقنية.

إلا أن مديرة البرنامج الرقمي في منظمة حقوق الإنسان البريطانية المهتمة بالآثار الاجتماعية والقانونية للتقنيات الناشئة، فيدوشي ماردا، تعارض وجهة نظر تشين بشأن حادث الطعن في جوانجشي، «هذه رواية مألوفة ومحبطة بعض الشيء، يتم استخدامها بشكل متكرر عند تقديم تقنيات أحدث تحت مظلة السلامة أو الأمن، ولكن في الواقع ليس للمراقبة بالفيديو أي ارتباط بتدابير السلامة سوى القليل من الحالات». وتمضي قائلة «أعتقد أن الكثير من المراقبة البيومترية مرتبطة ارتباطاً وثيقاً بالترهيب والرقابة، وأعتقد أن تقنية التعرف إلى المشاعر هي أحد الأمثلة على ذلك».

مشكلة أخرى هي أن أنظمة التعرف عادة ما تعتمد على ممثلين يتظاهرون أمام الكاميرات بأنهم سعداء وحزينون وغاضبون ويمثلون حالات وجدانية أخرى، كما يمكن أن تختلف تعبيرات الوجه أيضاً على نطاق واسع عبر الثقافات، ما يؤدي إلى مزيد من عدم الدقة والتحيز العرقي.

نظام تغوسيس الصيني المستخدم من قبل الشرطة الصينية، فضلاً عن الأجهزة الأمنية التي تصدرها الشركة لتايلاند وبعض الدول الإفريقية، تتضمن مُعرِّفات لألوان الناس مثل الأصفر والأبيض والأسود. ويقول تشين، مشيراً إلى العرق السائد في البلاد: «السكان في تلك البلدان أكثر تنوعاً عرقياً مقارنة بالصين، وفي الصين تُستخدم هذه المعرفات أيضاً لتحديد الأويغور من الهان الصينيين، في إشارة الى العرق الغالب في الصين، فإذا ظهر أحد الأويغور، يضع الجهاز علامة عليه، لكنه لا يضع العلامة على الهان». ولدى سؤاله عما إذا كان قلقاً بشأن إساءة استخدام السلطات لهذه الميزات، قال تشين إنه ليس قلقاً لأن البرنامج تستخدمه الشرطة، ما يعني ضمناً أنه يجب الوثوق بهذه المؤسسات تلقائياً.

وبالنسبة للباحثة الزائرة بمعهد جامعة نيويورك فإن التمييز بين الأعراق يعتبر مبرراً كريهاً، وتمضي قائلة «إن المفاهيم الصينية للعرق التي يتم دمجها في التكنولوجيا وتصديرها إلى أجزاء أخرى من العالم أمر مقلق حقاً، لاسيما أنه لا يوجد نوع من الخطاب النقدي حول العنصرية والعرق في الصين مثلما هو الحال في الولايات المتحدة».

وتقول: أظهرت التقارير البحثية والاستقصائية على مدى السنوات القليلة الماضية أن المعلومات الشخصية الحساسة تصبح خطيرة بشكل خاص عندما تكون في أيدي كيانات الدولة، لاسيما بالنظر لاستخدامها المحتمل من قبل الجهات الحكومية.

أحد مسببات رواج قطاع تقنية التعرف إلى المشاعر في الصين هو افتقار البلاد لقوانين الخصوصية الصارمة. لا توجد في الأساس قوانين تمنع السلطات من الوصول إلى البيانات البيومترية، حيث يتم استخدام هذه البيانات لمبررات تتعلق بالأمن القومي أو السلامة العامة، ما يمنح شركات مثل تغوسيس الحرية الكاملة في تطوير هذه المنتجات وطرحها في الوقت الذي لا تستطيع فيه الشركات المماثلة في الولايات المتحدة أو اليابان أو أوروبا عمل ذلك.

• أحد مسببات رواج قطاع تقنية التعرف إلى المشاعر في الصين هو افتقار البلاد لقوانين الخصوصية الصارمة.

• إن المفاهيم الصينية للعرق التي يتم دمجها في التكنولوجيا وتصديرها إلى أجزاء أخرى من العالم أمر مقلق حقاً، لاسيما أنه لا يوجد نوع من الخطاب النقدي حول العنصرية والعِرق في الصين مثلما هو الحال في الولايات المتحدة.

• أنظمة التعرف عادة ما تعتمد على ممثلين يتظاهرون أمام الكاميرات بأنهم سعداء وحزينون وغاضبون ويمثلون حالات وجدانية أخرى، كما يمكن أن تختلف تعبيرات الوجه أيضاً على نطاق واسع عبر الثقافات، ما يؤدي إلى مزيد من عدم الدقة والتحيز العرقي.

![]() تابعوا آخر أخبارنا المحلية والرياضية وآخر المستجدات السياسية والإقتصادية عبر Google news

تابعوا آخر أخبارنا المحلية والرياضية وآخر المستجدات السياسية والإقتصادية عبر Google news